Trí tuệ nhân tạo (AI) đang len lỏi vào mọi mặt của cuộc sống — từ sáng tạo nội dung, hỗ trợ học tập, chăm sóc sức khỏe đến lập trình phần mềm. Tuy nhiên, sự tiện lợi mà AI mang lại cũng tiềm ẩn một nguy cơ đang ngày càng rõ ràng: AI càng ngày càng bịa chuyện khéo léo hơn, nó tạo ra một hiện tượng “ảo giác AI” — khi mà AI tự tin tạo ra thông tin sai lệch như thể đó là sự thật hiển nhiên. Và điều đáng lo ngại hơn cả là nhiều người dùng lại tin vào những điều "bịa như thật" ấy mà không mảy may nghi ngờ.

Khi AI nói sai… nhưng nghe rất đúng

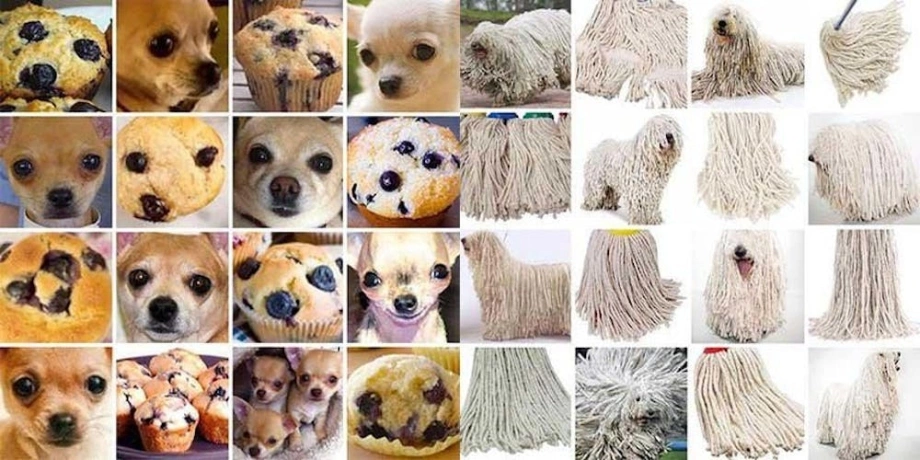

Khác với các lỗi hiển nhiên như cú pháp sai hay logic không hợp lý, “ảo giác AI” là hiện tượng khi một mô hình AI tạo ra thông tin sai, nhưng trình bày nó một cách mạch lạc, có dẫn chứng, và thậm chí còn “trích dẫn nguồn” — dù nguồn đó có thể… không tồn tại. Điều này đặc biệt nguy hiểm trong bối cảnh AI ngày càng được tin tưởng như một công cụ tư vấn, hỗ trợ tìm kiếm thông tin và thậm chí là viết thay con người.

Một freelancer tại TP.HCM chia sẻ rằng anh thường dùng AI để viết nội dung cho khách hàng. Trong một lần vội vàng, anh suýt gửi một bài viết do AI tạo ra mà không kiểm tra lại, vì nội dung nghe rất hợp lý. May mắn thay, trong lần rà soát cuối cùng, anh phát hiện một số dẫn chứng hoàn toàn không có thật.

Tại Hà Nội, một sinh viên sử dụng AI để học ngữ pháp tiếng Anh cũng đã gặp tình huống tương tự. Những ví dụ mà AI đưa ra nghe có vẻ “đúng bài bản”, nhưng khi đối chiếu với giáo viên, mới phát hiện phần lớn là sai. Nếu không được nhắc nhở, có lẽ bạn sinh viên ấy sẽ tiếp tục học sai và tích lũy kiến thức lệch lạc.

Ngay cả trong lĩnh vực kỹ thuật tưởng chừng như khắt khe và logic, một kỹ sư phần mềm ở Đà Nẵng cho biết đã từng nhận đoạn mã do AI gợi ý. Về mặt cú pháp, đoạn mã không có lỗi, nhưng logic lại hoàn toàn sai. Nếu đưa vào hệ thống thật, hậu quả có thể là những lỗi nghiêm trọng, ảnh hưởng đến toàn bộ quy trình vận hành.

Vì sao AI có thể "bịa chuyện"?

Cần hiểu rằng, AI như ChatGPT hay các mô hình ngôn ngữ khác không thực sự “hiểu” thông tin như con người. Chúng hoạt động dựa trên khả năng dự đoán từ tiếp theo trong một câu dựa trên hàng tỷ câu mẫu đã học. Khi gặp một câu hỏi mà nó chưa từng “thấy” trong dữ liệu huấn luyện, AI sẽ cố gắng “điền vào chỗ trống” bằng một câu trả lời có vẻ hợp lý — dù thông tin đó không hề có thật.

Đây chính là mấu chốt của hiện tượng “ảo giác AI”. Nó không phải lỗi kỹ thuật mà là giới hạn bản chất của cách mà AI hiện nay đang được xây dựng.

Người dùng có đang quá dễ dãi với AI?

Một trong những nguyên nhân khiến hiện tượng này trở nên nguy hiểm là bởi người dùng thường đặt niềm tin quá lớn vào AI. Sự trơn tru trong ngôn ngữ, tốc độ phản hồi và cảm giác "có logic" khiến nhiều người bỏ qua bước kiểm chứng. Với tâm lý “AI là máy móc, chắc không sai đâu”, người dùng dễ dàng tiếp nhận thông tin mà không kiểm tra lại.

Trong khi đó, các chuyên gia công nghệ vẫn liên tục cảnh báo rằng AI không thể thay thế được hoàn toàn con người trong những quyết định cần độ chính xác cao. Tại các nước phát triển, người ta đang thúc đẩy việc dạy kỹ năng "AI literacy" (hiểu biết về AI) trong trường học và công sở — điều mà ở Việt Nam vẫn còn khá mờ nhạt.

Hãy dùng AI như một công cụ, không phải người phán xử

AI không phải “người phán xử” có thể quyết định thay chúng ta điều gì là đúng hay sai. Thay vào đó, nó nên được nhìn nhận là một công cụ hỗ trợ — giống như chiếc máy tính giúp chúng ta tính toán nhanh hơn, nhưng vẫn cần con người hiểu bản chất con số.

Khi dùng AI để viết, lập trình, học tập hay thậm chí là tìm hiểu kiến thức, hãy đặt ra câu hỏi: Liệu mình có thể kiểm chứng điều này không? Nếu không chắc chắn, hãy tra cứu thêm từ những nguồn đáng tin cậy, hoặc tham khảo ý kiến của chuyên gia trong lĩnh vực liên quan.

Thế giới kỳ lạ của “ảo giác AI” là một lời nhắc nhở rằng, trong khi công nghệ có thể thay đổi cách chúng ta sống và làm việc, thì khả năng tư duy phản biện và kiểm chứng thông tin vẫn là kỹ năng cốt lõi không thể thay thế. Đừng để mình bị "bùa mê" bởi những lời nói trơn tru của một cỗ máy không có cảm xúc — hãy tỉnh táo, kiểm tra, và sử dụng AI một cách thông minh.