Trong một động thái gây tranh cãi, Google đã âm thầm cập nhật bộ quy tắc đạo đức về trí tuệ nhân tạo (AI), loại bỏ những cam kết trước đây về việc không áp dụng AI vào các mục đích có hại. Đây là một thay đổi đáng chú ý, đặc biệt khi AI ngày càng có vai trò quan trọng trong đời sống con người và được tích hợp sâu vào nhiều lĩnh vực, bao gồm cả quân sự và an ninh.

Google từng cam kết gì về AI?

Trước đây, Google đã công khai lập trường rõ ràng về việc phát triển AI có trách nhiệm, đặt ra những nguyên tắc cụ thể để đảm bảo AI không bị lạm dụng. Năm 2018, công ty tuyên bố sẽ KHÔNG tham gia phát triển AI phục vụ vũ khí, hệ thống giám sát hàng loạt hoặc các công nghệ có thể gây tổn hại cho con người và vi phạm các chuẩn mực đạo đức quốc tế. Đây được coi là một bước đi đúng đắn trong bối cảnh AI đang phát triển mạnh mẽ và đặt ra nhiều vấn đề liên quan đến đạo đức và trách nhiệm xã hội.

Tuy nhiên, trong bản cập nhật mới đây, Google đã âm thầm loại bỏ những điều khoản này. Việc thay đổi này nhanh chóng thu hút sự quan tâm của dư luận và giới công nghệ, làm dấy lên nhiều câu hỏi về mục tiêu và định hướng phát triển AI của công ty trong tương lai.

Sự thay đổi trong quy tắc đạo đức AI của Google

Khi được hỏi về lý do của sự thay đổi này, Google dẫn chiếu đến một bài đăng trên blog chính thức của họ, trong đó nhấn mạnh về "AI có trách nhiệm". Theo Google, công ty cam kết hợp tác với chính phủ, các tổ chức và các đối tác trong ngành để phát triển AI theo hướng bảo vệ con người, thúc đẩy tăng trưởng kinh tế và hỗ trợ an ninh quốc gia.

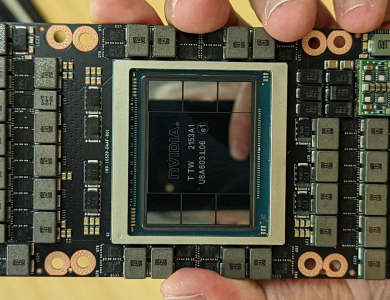

Dù vậy, việc gỡ bỏ những cam kết trước đây khiến nhiều người lo ngại rằng Google có thể đang mở đường cho những ứng dụng AI mang tính rủi ro cao hơn, đặc biệt là trong lĩnh vực quân sự. Việc Google từng cung cấp dịch vụ đám mây cho quân đội Mỹ đã khiến không ít nhân viên công ty phản đối và cảnh báo về những hậu quả tiềm tàng.

AI và những mối nguy tiềm ẩn

AI đang ngày càng trở thành một công cụ mạnh mẽ có thể được sử dụng trong nhiều lĩnh vực, từ y tế, tài chính đến an ninh và quân sự. Nếu không có các quy tắc rõ ràng và sự kiểm soát chặt chẽ, AI có thể bị lạm dụng vào các mục đích tiêu cực, chẳng hạn như:

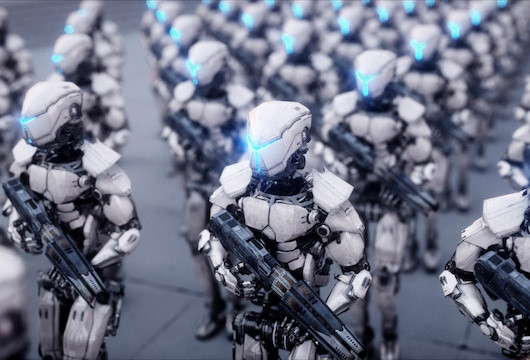

- Vũ khí tự động: AI có thể được sử dụng để phát triển các loại vũ khí tự động hóa cao, giảm thiểu sự can thiệp của con người trong chiến tranh, nhưng cũng tiềm ẩn nguy cơ mất kiểm soát.

- Giám sát hàng loạt: AI có thể bị lợi dụng để theo dõi, thu thập dữ liệu cá nhân và kiểm soát người dân trên quy mô lớn.

- Thiên vị thuật toán: Nếu không được thiết kế cẩn thận, AI có thể tạo ra những định kiến không công bằng, dẫn đến việc phân biệt đối xử hoặc thao túng thông tin.

Chính vì những nguy cơ này, các công ty công nghệ lớn như Google, Microsoft hay OpenAI đều từng đưa ra các quy tắc đạo đức để giới hạn phạm vi ứng dụng AI. Nhưng với động thái mới nhất của Google, liệu những nguyên tắc này có còn giữ nguyên giá trị?

Tương lai của AI: Chúng ta cần chuẩn bị gì?

Việc Google gỡ bỏ cam kết không ứng dụng AI vào các mục đích có hại cho thấy một xu hướng rõ ràng: các tập đoàn công nghệ đang dần linh hoạt hơn trong việc triển khai AI vào nhiều lĩnh vực, bao gồm cả những lĩnh vực nhạy cảm như an ninh và quốc phòng.

Tuy nhiên, điều này cũng đặt ra thách thức lớn về mặt đạo đức và pháp lý. Chính phủ các nước, các tổ chức quốc tế và giới nghiên cứu cần sớm đưa ra các quy định cụ thể để kiểm soát việc phát triển và ứng dụng AI. Nếu không có các giới hạn rõ ràng, AI có thể trở thành con dao hai lưỡi, mang lại cả lợi ích lẫn những rủi ro nghiêm trọng cho xã hội.

Câu hỏi đặt ra là: AI sẽ được kiểm soát như thế nào để không bị lạm dụng? Các chính phủ và tổ chức có thể làm gì để đảm bảo AI phục vụ lợi ích chung mà không trở thành mối đe dọa? Đây là những vấn đề quan trọng mà cả thế giới cần cùng nhau giải quyết trước khi AI phát triển đến mức vượt quá khả năng kiểm soát của con người.