Trong khi ngành trí tuệ nhân tạo đang có những bước tiến như vũ bão khiến nhiều người tin rằng một ngày không xa, các hệ thống AI có thể thay thế con người trong nhiều lĩnh vực, thậm chí vượt qua chúng ta trong một số khía cạnh. Các nhà khoa học đã thực hiện một thử nghiệm mới đây với tên gọi – "Kỳ thi cuối cùng của nhân loại" (Humanity's Last Exam – HLE) – nhằm mang lại một cái nhìn thực tế và thận trọng hơn về năng lực thực sự của các mô hình ngôn ngữ lớn (LLM) hiện nay như ChatGPT, Gemini hay DeepSeek.

HLE – Kỳ thi đánh giá AI một cách toàn diện

HLE là một dự án được tổ chức bởi Trung tâm An toàn AI (Center for AI Safety) phối hợp với công ty Scale AI – một cái tên quen thuộc trong lĩnh vực xử lý dữ liệu và huấn luyện AI. Khác với những bài kiểm tra thông thường mà các mô hình ngôn ngữ có thể "lướt qua" dễ dàng nhờ vào khả năng truy xuất thông tin khổng lồ từ dữ liệu huấn luyện, kỳ thi này được thiết kế cực kỳ nghiêm ngặt, nhằm đánh giá năng lực hiểu sâu và suy luận thật sự của AI.

Với hơn 2.700 câu hỏi do các chuyên gia trên khắp thế giới đóng góp, HLE trải dài qua nhiều lĩnh vực từ Toán học (chiếm khoảng 41%), Y học, Vật lý, Hóa học, Khoa học máy tính, Kỹ thuật cho đến Nhân văn học. Điểm đặc biệt là các câu hỏi trong kỳ thi đều được xây dựng để có đáp án duy nhất và tránh tối đa khả năng "tìm kiếm câu trả lời" từ bên ngoài – điều mà AI thường làm rất tốt. Đây thực sự là một cuộc thi "chơi khó" các mô hình AI.

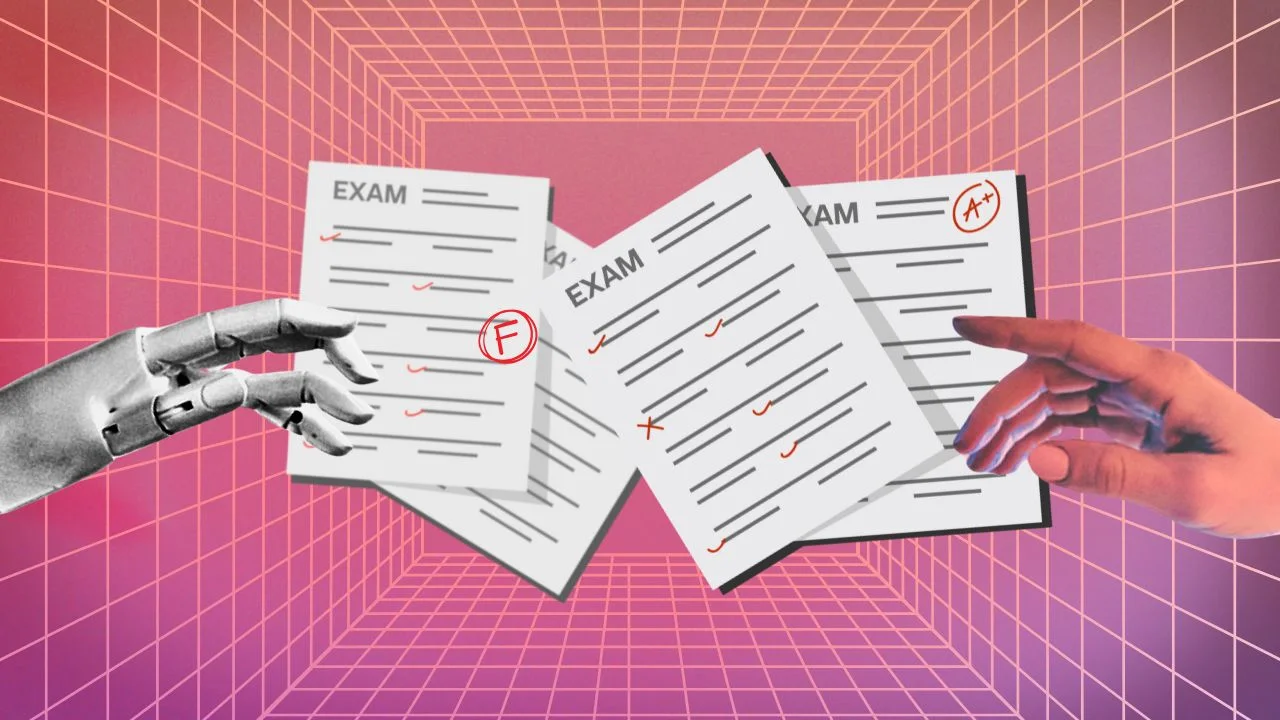

Kết quả như dự đoán: các mô hình hàng đầu đều... trượt

Nhiều mô hình ngôn ngữ tiên tiến đã được đưa vào thử nghiệm. Kết quả: Đa số đều trượt một cách thảm hại.

Theo công bố từ nhóm nghiên cứu, một số mô hình (bao gồm Gemini và DeepSeek) chỉ đạt được mức chính xác từ 3% đến 14%, một con số quá thấp so với kỳ vọng và thậm chí còn không vượt qua nổi ngưỡng "đoán mò". Điều này cho thấy mặc dù các AI hiện nay có thể tạo ra văn bản mượt mà, thuyết phục, nhưng khi bị thử thách ở mức độ cao hơn – nơi đòi hỏi sự hiểu biết bản chất, tư duy logic và phản biện – thì chúng vẫn còn kém xa con người.

Đây là một lời nhắc nhở quan trọng rằng khả năng "nói như thật" không đồng nghĩa với "hiểu thật". Chúng ta không nên bị đánh lừa bởi các đoạn hội thoại trơn tru hay những bài viết có vẻ uyên bác mà AI tạo ra. Bên trong những câu từ đó, có thể hoàn toàn vắng bóng sự hiểu biết sâu sắc.

Vì sao AI thất bại – và hy vọng nào cho tương lai?

Một trong những lý do chính khiến các mô hình AI hiện nay thất bại trong HLE là vì chúng thiếu khả năng đánh giá mức độ không chắc chắn của chính mình. AI có thể "tự tin trả lời sai" trong những tình huống mà con người, nếu không chắc chắn, có thể thừa nhận "Tôi không biết".

Nhóm nghiên cứu tin rằng để cải thiện điều này, một bước tiến quan trọng sẽ là huấn luyện AI để nhận biết khi nào mình không biết – và từ đó học cách im lặng hoặc cảnh báo về độ tin cậy thấp của câu trả lời. Đây là điều cực kỳ quan trọng khi áp dụng AI vào các lĩnh vực mang tính sống còn như y học, luật pháp hay tài chính, nơi một sai sót nhỏ có thể dẫn đến hậu quả nghiêm trọng.

Dù kết quả hiện tại chưa khả quan, các chuyên gia lạc quan rằng với tốc độ phát triển nhanh chóng như hiện nay, AI có thể đạt độ chính xác 50% trong kỳ thi này vào cuối năm 2025. Điều đó đồng nghĩa với việc trong vòng chưa đến 2 năm, chúng ta có thể chứng kiến những AI đủ thông minh để vượt qua những bài kiểm tra khắt khe nhất mà con người từng đặt ra.

Trượt hôm nay để tiến xa ngày mai

Việc các AI trượt trong "Kỳ thi cuối cùng của nhân loại" không phải là một thất bại hoàn toàn. Ngược lại, nó là một bước ngoặt quan trọng, là tấm gương phản chiếu sự thật về khả năng hiện tại của AI – đồng thời chỉ ra những hướng đi cần cải thiện nếu chúng ta muốn AI trở thành người đồng hành đáng tin cậy trong tương lai.

HLE không đơn thuần là một kỳ thi. Nó là một lời nhắc nhở rằng dù AI đã rất thông minh, nhưng vẫn còn rất nhiều điều nó chưa hiểu. Và điều đó, ít nhất là hiện tại, vẫn giữ cho con người một vị trí đặc biệt trong thế giới tri thức.